Ирония состояла в том, что потребности в более оперативной аналитике и отчетности не существовало, поскольку сам бизнес не мог реагировать на них намного быстрее. В начале моей карьеры при разработке модели кампании прямой рассылки мы использовали данные трех-четырехнедельной давности для определения домохозяйств, которые следует включить в рассылку. Затем составленный нами список отправлялся в отдел рассылки, а ему требовалось еще две недели, чтобы напечатать рекламные материалы и отправить их по указанным адресам. Наконец, проходила еще неделя, прежде чем письма доставлялись в почтовые ящики адресатов. Это означало, что между моментом сбора данных и тем временем, когда результаты анализа могли повлиять на клиентов и бизнес, проходило шесть, а то и восемь – десять недель. Ускорять аналитические процессы не имело смысла, поскольку рассылки осуществлялись по фиксированному месячному графику и списки требовались с той же регулярностью. Легко понять, почему в такой среде многие аналитические процессы не реализовывали свой потенциал в полной мере.

Аналитика 2.0: аналитика больших данных

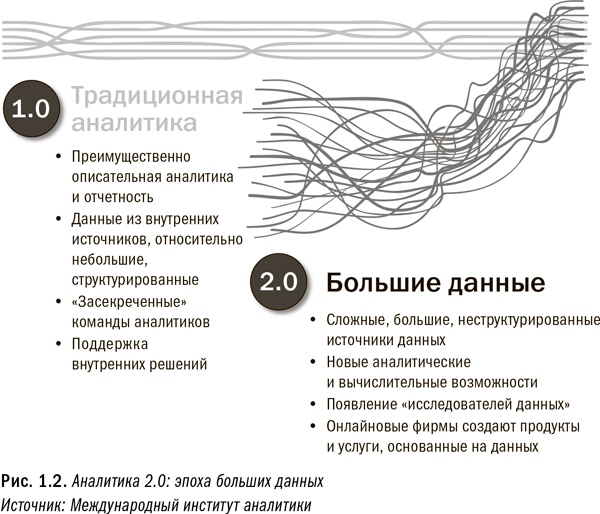

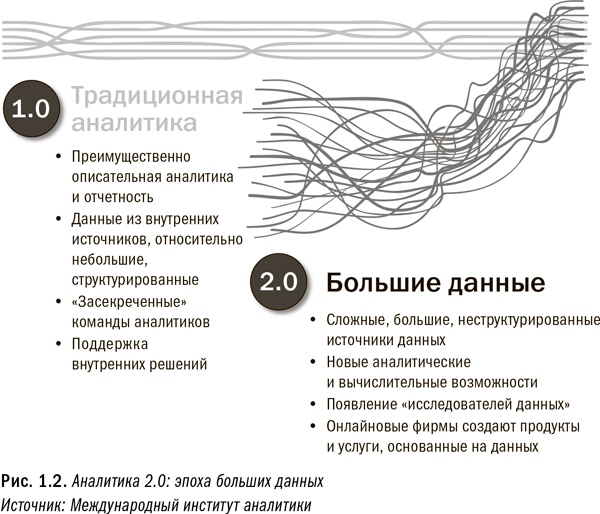

В начале 2000-х началась эпоха Аналитики 2.0, открывшая перед нами мир больших данных

{3}. Они во многих отношениях были новинкой – зачастую гораздо объемнее и сложнее, чем данные, которые использовались в эпоху Аналитики 1.0, и при этом необязательно так же структурированные. Большие данные могли включать в себя все что угодно – от документов, фотографий и видео до сенсорных данных. Множество больших данных, используемых для анализа, поступают из внешних источников, например социальных сетей. Несмотря на свое внешнее происхождение, они могут оказаться очень ценными.

Сегодня, в эпоху Аналитики 2.0, как видно на рис. 1.2, мы обнаружили, что для обработки больших данных и выполнения разнообразных аналитических процессов нам нужны новые аналитические технологии и новые вычислительные возможности. В результате из забвения на свет вышли такие технологии, как Hadoop (о ней мы расскажем позднее), а аналитические процессы были модернизированы, чтобы соответствовать этим новым технологиям. Основное внимание в эпоху Аналитики 2.0 сосредоточено на поиске наиболее дешевых способов сбора и хранения необработанных данных, а уже затем на поиске способов их применения.

Отчетливо выраженным трендом стало недавнее появление «науки о данных», изучающей способы анализа больших данных профессиональными аналитиками, а также такой профессии, как «исследователи данных». Основное различие между ними и традиционными профессиональными аналитиками состоит в выборе инструментов и платформ, используемых для анализа. Традиционные профессиональные специалисты в крупных организациях склонны использовать такие инструменты, как SAS и SQL, для анализа базы данных в окружении реляционной базы данных. Исследователи данных чаще применяют такие инструменты, как R и Python, для анализа данных в окружении Hadoop. Тем не менее эти различия носят тактический и в основном семантический характер. Любой специалист, хорошо разбирающийся в том или другом окружении, легко может переключаться между ними. Несмотря на разные наименования, профессиональные аналитики обладают практически одинаковыми базовыми наборами навыков и складом ума. (Подробнее мы обсудим эту тему в восьмой главе.)

В эпоху Аналитики 2.0 профессиональные аналитики хотя и не были включены в процесс принятия решений, но повысили свой статус в организациях до такого уровня, что могут напрямую влиять на принимающих решения лиц. Профессиональные аналитики перестали быть секретным ресурсом, тщательно огражденным от бизнес-сообщества.

Как мы увидим далее в этой главе, многие организации, особенно фирмы, работающие онлайн и в области электронной коммерции, начали разрабатывать коммерческие продукты и услуги, основанные исключительно на данных и аналитике. Первыми это предприняли онлайновые фирмы, они же первыми вступили в эпоху Аналитики 2.0. Одним из самых примечательных примеров является социальная сеть LinkedIn, создавшая такие продукты, как «Люди, которых вы можете знать» и «Группы, которые вам могут понравиться». Такие основанные на аналитике продукты используют информацию, собираемую в рамках управления и поддержания аккаунтов пользователей, и генерируют новую информацию, за которую во многих случаях пользователи платят.

Один из парадоксов Аналитики 2.0 состоит в том, что производимая аналитика зачастую оказывается не очень-то и продвинутой. Отчасти это было обусловлено тем, что объем и сложность данных затрудняют их перевод в пригодный для анализа формат. Отчасти объясняется незрелостью источников данных и аналитических инструментов. При всем поднятом вокруг нее ажиотаже эпоха Аналитики 2.0 по-прежнему в значительной степени опирается на отчетность и описательную аналитику с относительно малыми вкраплениями прогностической и предписывающей аналитики.

Одной лишь Аналитики 2.0 недостаточно

Эпоха Аналитики 2.0 выводит на передний план большие данные и новые возможности для применения аналитики. При этом нецелесообразно создавать отдельные команды, технологии и инструменты исключительно для анализа больших данных. Аналитические процессы должны охватывать любые данные и соответствовать любым требованиям, предъявляемым к аналитике. Вот почему Аналитика 2.0 – это не конечный результат.

Одно из заблуждений, характерных для эпохи Аналитики 2.0, проистекает из того факта, что многие профессиональные аналитики не прошли через эпоху Аналитики 1.0. Многие из них имеют подготовку в области компьютерных наук и пришли в аналитику из технологической сферы. Порой аналитики поколения 2.0 попросту не знают всего того, что делали крупные инновационные компании в эпоху Аналитики 1.0. Как следствие, они могут предположить, что все используемые ими концепции и методики являются совершенно новыми. Иногда это действительно так, но чаще всего нет. Давайте рассмотрим пример, который иллюстрирует эту ситуацию.

Как-то на конференции я услышал выступление одного молодого человека. Не буду называть его имя и компанию, поскольку моя цель – пролить свет на распространенную логическую ошибку, а не поставить кого-то в неловкое положение. Докладчик подробно изложил методы, посредством которых он со своей командой разрабатывал разнообразные аналитические процессы для сайта электронной коммерции его компании. И доводы, и методы были вполне разумными. Компания поступала правильно: например, применяла аффинитивный анализ и совместную фильтрацию для определения того, какие дополнительные продукты могли заинтересовать клиента исходя из истории его прошлых покупок и просмотров. Такого рода анализ традиционные ретейлеры применяли на протяжении многих лет.

Однако докладчик ошибочно заявил, что метод аффинитивного анализа нельзя было применять до появления больших данных и некоторых новых технологий. Он искренне верил в то, что применение широко распространенных алгоритмов открывает новые горизонты, поскольку не имел представления о происходившем на протяжении многих лет в традиционной розничной торговле. Метод аффинитивного анализа оказался в новинку только для этого молодого специалиста (и подобных ему). Парень попросту не знал истории аналитики. Действительно, в атмосфере ажиотажа вокруг больших данных легко предположить, что в прошлом ничего интересного не происходило. К сожалению, из-за такой неосведомленности можно потратить массу времени на выработку давно уже существующих решений, вместо того чтобы заняться более полезным делом.