Существует два типа t-теста:

• для независимых выборок, когда две сравниваемые группы никак друг от друга не зависят;

• парный (paired) для зависимых выборок, когда две сравниваемые группы зависят друг от друга.

Как правило, критерий применяется в тех случаях, когда испытуемых разделяют на две независимые группы, именно об этом мы и поговорим. Например, пациентов могут разделить на две группы: контрольную, которой дают плацебо, и ту, на которой испытывают реальные лекарства (экспериментальная группа). Таким образом, мы можем получить сразу много данных о каждой группе: какими были интересующие нас показатели (например уровень глюкозы в плазме крови) в группе плацебо до «лечения» и после? А в экспериментальной? Можно сравнить результаты исследований до начала активной фазы исследований и после. Тогда мы поймём, влияет ли как-то наше вмешательство на исследуемые параметры или нет.

Например, наше лекарство должно снижать уровень глюкозы в плазме крови. Если мы честные исследователи, то пациентов в каждую из групп, контрольную и экспериментальную, мы выбирали одинаково по тем же самым параметрам. Значит, и различий между группами по показателю содержания глюкозы в плазме крови до приёма плацебо и лекарства соответственно быть не должно. Но если наше лекарство действует лучше, чем ничего (пустышка-плацебо), значит, после лечения уровень глюкозы должен будет отличаться между группами. Так как глюкоза у нас в организме содержится в строго определённых пределах (меньше и больше определённых значений, к сожалению, означает смерть), а в норме натощак встречается в пределах примерно от 3.5 до 5.5 ммоль/л, можно заранее предположить нормальное распределение. Конечно, наше предположение никак не освобождает нас от необходимости проверки на нормальность: вдруг мы какие-то аномалии получили? Но если нормальность распределения подтверждается, можно использовать t-критерий Стьюдента.

Парный t-тест используется в тех случаях, когда исследователь не разделяет испытуемых на две группы. Они все изначально принадлежат сначала одной группе и проходят через одни и те же процедуры. Исследователь документирует все изменения, которые происходили до и после этих процедур с пациентами. После того, как все эффекты пропадают, пациентов начинают лечить по второй схеме. Все изменения фиксируются и на этом этапе. Парный критерий Стьюдента используется для перекрёстного сравнения таких двух подходов на одних и тех же пациентов, при этом оцениваются одни и те же величины.

Благодаря своей простоте и возможности применения даже на смартфоне при помощи калькулятора этот метод является одним из самых популярных в научной среде. Более того, повсеместность использования t-критерия позволяет вам как исследователю не только сравнивать что-то там у себя в больнице, но и обмениваться данными с коллегами по всему миру. Ведь если вы используете одни и те же методы для обработки данных, которые были собраны одинаково, вы имеете полное право сравнивать их между собой (а потом хвастаться, что у ваших пациентов, мол, показатели куда лучше, чем в соседней поликлинике). Однако не следует забывать, что верные данные и представления о результатах проведённого исследования можно получить тогда и только тогда, когда была правильно проведена вся подготовительная работа.

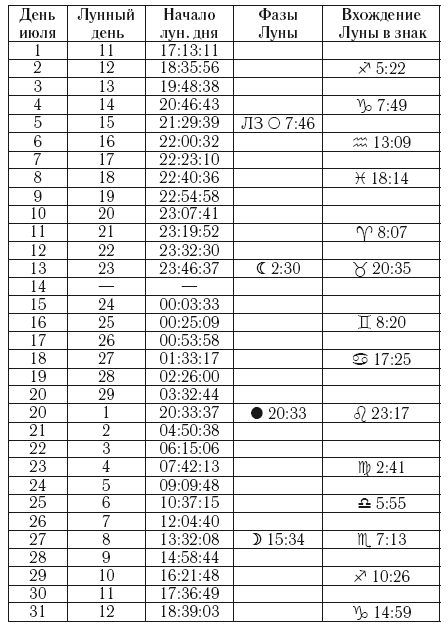

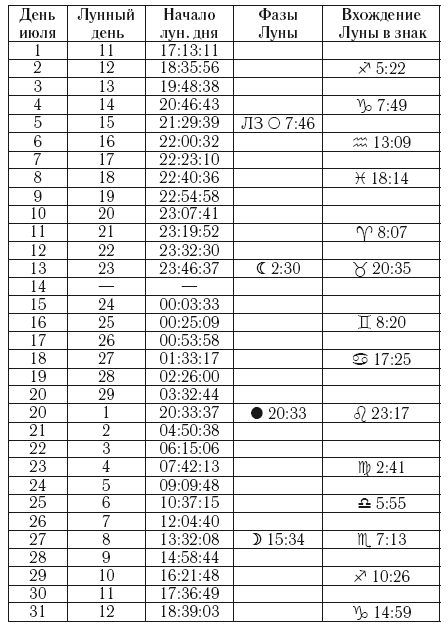

Для тех, кто захочет самостоятельно что-то вычислить, рекомендую начать с обыкновенных вычислений в Microsoft Excel. Все необходимые формулы легко можно найти в Гугле, только не забудьте заранее найти критические значения t по таблице. Для этого вам необходимо будет выбрать уровень значимости α и знать размер выборки. Этот случай – один из тех, когда первым ссылкам в поиске можно с лёгкостью доверять (рис. 9).

Рис. 9. Фрагмент таблицы со значениями t-критерия для разных уровней значимости и размеров выборки (n)

Множественные сравнения. Наверное, это самая больная мозоль многих исследований, к сожалению, чаще отечественных. Очень часто критерий Стьюдента неверно используется для того, чтобы оценить различия в большем числе групп. Напоминаю, что с помощью t-теста мы можем сравнить только две группы. Некоторые неопытные исследователи (ну или недобросовестные, чего уж греха таить) начинают сравнивать группы попарно. Например, всего было 3 группы, значит, можно сравнить 1 с 2, 2 с 3 и 1 с 3, после чего радостно публиковаться в не самом лучшем журнале (потому что в хороший не возьмут). Если в каких-то сравнениях такой исследователь получает заветное p < 0.05, он с уверенностью заверяет читателей в отличиях между группами, однако не учитывает факта множественных сравнений. По сути-то мы наши выборки использовали не в одном сравнении, а сразу в трёх! Для одного сравнения мы принимали вероятность ошибки в 5 %, но если количество сравнений увеличивается, на том же уровне значимости необходимое значение p также изменяется. Если прикидывать грубо, то в случае горе-исследователя вероятность ошибиться хотя бы в одном сравнении будет примерно 15 %.

Для избегания таких ошибок нужно применять специальные поправки на множественные сравнения. Их существует большое количество, для каждого конкретного случая лучше выбирать определённые поправки вручную с учётом целей исследования и полученных выборок. Самой грубой и простой является поправка Бонферрони, когда новый уровень значимости вычисляется простым делением начального уровня значимости на количество сравнений. То есть в случае с тремя группами (и тремя сравнениями) при уровне значимости 0.05 мы получим: 0.05: 3 = 0.017. Значит, значение p должно быть меньше, чем 0.017, чтобы отличия между группами считались значимыми, иначе вероятность ошибки слишком велика. Поправка Бонферрони применяется не всегда, так как является простейшей и довольно грубой, она довольно резко отсекает верные ненулевые гипотезы. Считается, что она неплохо работает тогда, когда мы проводим небольшое количество попарных сравнений.

Корреляция. Существует такое понятие как корреляция, по-простому это как один параметр зависит от другого, и зависит ли вообще, если да, то в какой степени. Например, с увеличением роста, как правило, увеличивается масса тела, следовательно, эти две характеристики коррелируют между собой. Коэффициент корреляции Пирсона используют для того, чтобы описывать количественные признаки, которые подчиняются нормальному распределению. Существует также коэффициент корреляции Спирмена, который используют в тех случаях, когда о распределении ничего неизвестно.

Тут только нужно особенно отметить тот факт, что «correlation does not imply causation» – корреляция не подразумевает причинно-следственную связь. Самый, к слову, простой пример может показаться довольно банальным. Некоторые дети, которые совершали жестокие преступления, много смотрели телевизор, очевидно, что телевизионные программы делают детей более жестокими. Но на самом деле всё может быть совсем не так, а может и с точностью до наоборот: возможно, жестоким детям просто нравится смотреть телевизор больше, чем нежестоким.