Существует так много потенциальных «регрессионных ловушек», что я решил посвятить их рассмотрению всю следующую главу. Пока же будем считать, что на нашем пути ни одна из них не встретится. Регрессионный анализ обладает замечательным свойством вычленять в каждом отдельном случае статистическую связь, которая представляет для нас интерес, например связь между невозможностью человека в достаточной степени контролировать содержание, способы и условия выполнения своей работы и развитием сердечно-сосудистых заболеваний, учитывая при этом другие факторы, которые могут внести в нее искажения.

Как действует данный механизм? Если нам известно, что мелкие государственные служащие Британии курят чаще, чем их начальники, то как нам определить, в какой мере плохое состояние их сердечно-сосудистой системы обусловлено спецификой работы, а в какой – этой пагубной привычкой? Оба фактора кажутся неразрывно связанными между собой.

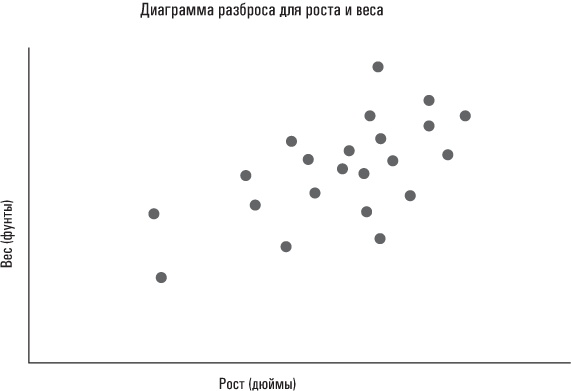

Регрессионный анализ (выполненный надлежащим образом!) позволяет разделить эти факторы. Чтобы объяснить процесс на интуитивном уровне, мне придется начать с базовой идеи, лежащей в основе всех форм регрессионного анализа, от простейших статистических связей до сложных моделей, разработанных лауреатами Нобелевской премии. По своей сути регрессионный анализ стремится найти «наилучшее приближение» линейной зависимости между двумя переменными. Простой пример – зависимость между ростом и весом людей. Те, кто выше ростом, как правило, весят больше, хотя эта закономерность соблюдается не всегда. Если бы мы построили диаграмму разброса для роста и веса группы студентов-выпускников, то получили бы нечто наподобие того, что уже видели в главе 4.

Если бы вас попросили описать получившуюся картину, вы бы наверняка сказали что-то вроде: «Вес, по-видимому, увеличивается пропорционально росту». Такую догадку вряд ли можно назвать озарением. Регрессионный анализ позволяет нам пойти дальше и «провести линию», которая точнее всего отражает линейную зависимость между этими двумя переменными.

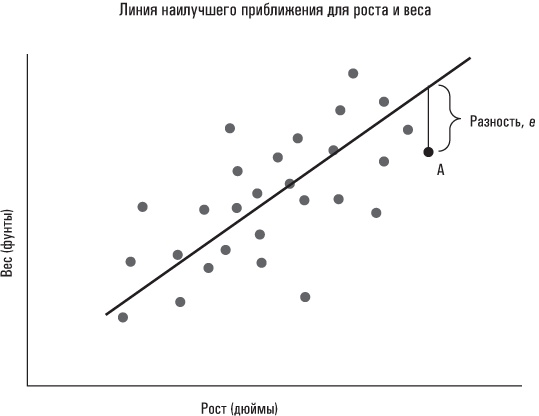

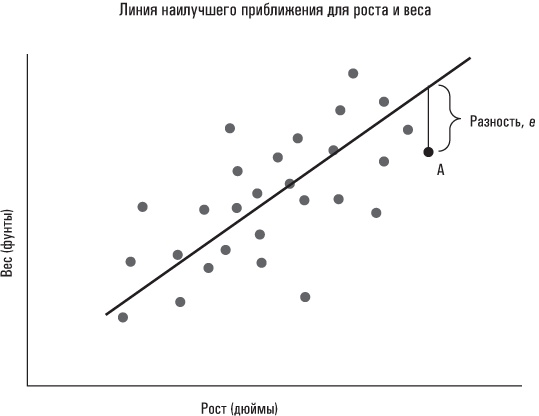

Можно провести множество линий, которые будут отражать соотношение между ростом и весом. Но как знать, какая из них это делает точнее всего? К тому же посредством какого критерия мы определяем эту линию? Регрессионный анализ обычно использует методологию под названием стандартный метод наименьших квадратов, МНК. Если читателя интересуют его технические подробности и он хочет узнать, почему МНК обеспечивает «наилучшее приближение», ему придется обратиться к более солидным учебникам по статистике. Ключевыми словами в названии МНК являются «наименьшие квадраты»: МНК определяет линию, минимизирующую сумму квадратов разностей. Это не настолько сложно, как может показаться на первый взгляд. Каждое наблюдение в нашей совокупности данных «рост/вес» характеризуется разностью, которая представляет собой его расстояние по вертикали от линии регрессии; это не относится к наблюдениям, расположенным непосредственно на линии: для них разность равняется нулю. (На представленной ниже диаграмме разброса разность отмечена для некоего гипотетического лица A.) На интуитивном уровне должно быть понятно, что чем больше сумма разностей в целом, тем худшее приближение обеспечивает данная линия. Единственное, что может быть непонятно в МНК на интуитивном уровне, это то, что в соответствующей формуле суммируются квадраты каждой разности (тем самым увеличивается весовой коэффициент, назначаемый наблюдениям, которые расположены особенно далеко от линии регрессии, то есть «отщепенцам»).

Обычный метод наименьших квадратов позволяет определить линию, которая минимизирует сумму квадратов разностей, как показано ниже.

Если технические подробности вызывают у вас головную боль, можете не обращать на них внимания. Важно запомнить главное: стандартный метод наименьших квадратов позволяет получить наилучшее описание линейной зависимости между двумя переменными. В результате мы получаем не только линию как таковую, но и – как вы, наверное, помните из курса геометрии в средней школе – уравнение, описывающее ее. Оно известно как уравнение регрессии и имеет следующий вид: y = a + bx, где y – вес в фунтах, a – отрезок, отсекаемый этой линией на оси Y (то есть значение y, когда x = 0), b – коэффициент наклона линии, а x – рост в дюймах. Коэффициент наклона b найденной нами линии описывает «наилучшую» линейную зависимость между ростом и весом для соответствующей выборки, как определяется стандартным методом наименьших квадратов.

Линия регрессии, конечно, не описывает идеальным образом каждое наблюдение в соответствующей совокупности данных. Но как бы то ни было, это лучшее из возможных описаний зависимости между весом и ростом человека. Это также означает, что каждое наблюдение можно объяснить как Вес = a + b(Рост) + e, где e – «разность», представляющая собой отклонение веса для каждого человека, которое не объясняется его ростом. Наконец, это означает, что наше оптимальное предположение относительно веса какого-либо человека в рассматриваемой совокупности даных будет иметь такой вид: a + b(Рост). Несмотря на то что большинство наблюдений не лежат непосредственно на линии регрессии, ожидаемая величина разности все же равняется нулю, поскольку вероятность того, что вес любого человека в выборке окажется больше, чем прогнозирует уравнение регрессии, равна вероятности того, что его вес окажется меньше, чем прогнозирует уравнение регрессии.

Впрочем, довольно теоретического жаргона! Давайте посмотрим на реальные данные роста и веса из исследования Americans’ Changing Lives. Правда, вначале мне придется прояснить кое-какую базовую терминологию. Переменная, которая подлежит объяснению, – в нашем случае это вес – называется зависимой переменной, так как она зависит от других факторов. Переменные, используемые для объяснения зависимой переменной, называются объясняющими переменными, поскольку они объясняют интересующий нас результат. (Чтобы еще больше запутать мозги, объясняющие переменные иногда называют независимыми или управляющими переменными.) Начнем с использования роста, чтобы объяснить вес участников исследования Americans’ Changing Lives, а впоследствии добавим другие потенциальные объясняющие факторы

[57]. В исследовании Americans’ Changing Lives участвуют 3537 взрослых. В нашем случае это количество наблюдений, или n. (Иногда в научных статьях это обозначается так: n = 3537.) Когда мы выполняем простую регрессию по отношению к данным Americans’ Changing Lives, где вес – зависимая переменная, а рост – единственная объясняющая переменная, то получаем следующие результаты: