Для загрузки целей в машину некоторые ученые предлагают другой подход, который обозначают модным словечком коррегируемость (corrigibility). В его основе лежит надежда на то, что примитивному искусственному интеллекту можно задать любую систему целей, потому что вы все равно его время от времени выключаете, а выключив, можете скорректировать и систему целей. Если это окажется возможным, тогда можно спокойно позволить своему искусственному интеллекту становиться сверхразумным, периодически выключая его и меняя ему систему целей, потом проверяя ее и, если результат окажется неудачным, выключая снова, чтобы проделывать новые манипуляции с целями

.

Но даже если вы сможете создать такой искусственный интеллект, который поймет и примет ваши цели, проблема соответствия его целей и ваших все еще останется нерешенной: что, если цели вашего искусственного интеллекта будут изменяться с его развитием? Чем вы сможете гарантировать, что он будет сохранять приоритет ваших целей в ходе рекурсивного самосовершенствования? Давайте исследуем один любопытной аргумент, показывающий, что автоматическое сохранение целей гарантировано, и затем посмотрим, найдем ли мы в нем слабые места.

Хотя мы не можем в точности предсказать, что произойдет после интеллектуального взрыва, — именно поэтому Вернор Виндж назвал это сингулярностью, — физик и исследователь искусственного интеллекта Стив Омохундро в бурно обсуждавшемся эссе 2008 года утверждал, что мы, тем не менее, можем предсказать некоторые аспекты поведения сверхразума, которые практически не зависят от его окончательных целей

. Это утверждение было подхвачено и дальше развито в книге Ника Бострёма Superintelligence. Основная идея состоит в том, что, каковы бы ни были конечные цели, сопутствующие им вспомогательные цели будут предсказуемыми. Ранее в этой главе мы видели, как цель воспроизведения привела к появлению вспомогательной цели утоления голода. Это означает, что если бы пришелец наблюдал за развитием бактерии на Земле миллиард лет назад, он не смог бы предвидеть, какие цели будут у людей, но мог бы с точностью предсказать, что одной из наших целей будет потребление питательных веществ. Заглядывая вперед, каких вспомогательных целей нам стоит ожидать от сверхразумного искусственного интеллекта?

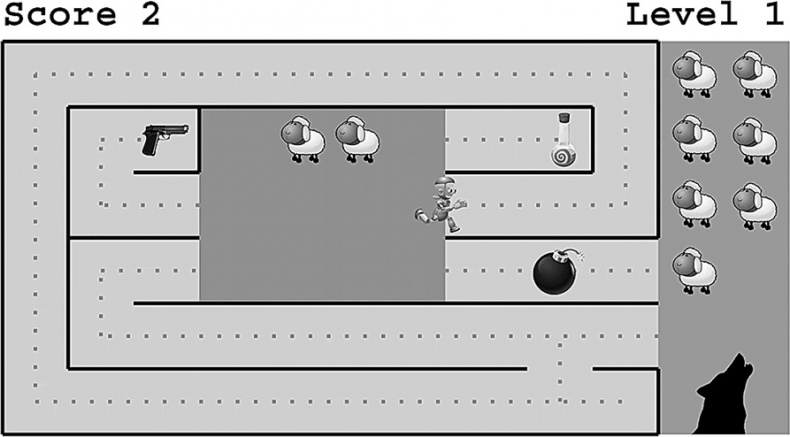

Я смотрю на это так: для увеличения шансов достичь своих конечных целей, какими бы они ни были, искусственный интеллект должен преследовать вспомогательные цели, представленные на рис. 7.2. Для достижения своих конечных целей он должен стараться не только улучшить свои возможности, но и убедиться, что он сохранит эти цели даже после того, как достигнет более высокой степени развития. Это звучит довольно правдоподобно: в конце концов, согласились бы вы имплантировать себе в мозг бустер, увеличивающий IQ, если бы знали, что он заставит вас желать смерти любимых? Аргумент, что любой быстро развивающийся искусственный интеллект сохранит свои конечные цели, лег краеугольным камнем в представление о дружелюбии, пропагандируемое Элиезером Юдковски с коллегами: оно говорит нам, что если мы сумеем добиться от самосовершенствующегося искусственного интеллекта дружелюбия через понимание и принятие наших целей, тогда мы в порядке — тем самым будет гарантировано, что он навсегда останется дружелюбным.

Но так ли это на самом деле? Чтобы ответить на этот вопрос, нам необходимо изучить другие вспомогательные цели на рис. 7.2. Очевидно, что искусственный интеллект сможет добиться максимальных шансов на достижение своих конечных целей, какими бы они ни были, если он сможет расширить свои способности, улучшая свой «хард», свой «софт»

[53] и модель мира. То же самое можно сказать и о людях: девочка, чья цель состоит в том, чтобы стать лучшей теннисисткой в мире, должна тренироваться, тем самым улучшая свой теннисно-мускулатурный «хард», свой нейронный «софт» и ментальную модель мира, которая поможет предсказать, что будет делать ее противник. Для искусственного интеллекта вспомогательная цель оптимизации «харда» подразумевает и как более качественное использование имеющихся ресурсов (сенсоров, преобразователей, вычислителей и т. д.), так и потребление бóльшего количества ресурсов. Это также относится и к потребности самозащиты, так как разрушение / отключение будет пагубно отражаться на «харде».

Рис. 7.2

Любая конечная цель сверхразумного искусственного интеллекта естественно приводит к возникновению вспомогательных целей, показанных на рисунке. Но между совершенствованием своих способностей и сохранением изначальных целей есть внутреннее противоречие, которое заставляет нас сомневаться, что искусственный интеллект будет сохранять исходную цель, становясь все более разумным.

Но секундочку! Не попали ли мы в ловушку и не стали ли наделять наш искусственный интеллект человеческими качествами, рассуждая о том, как он будет стараться приумножать ресурсы и защищать себя? Не должны ли мы ожидать такого стереотипного поведения альфа-самца только от разума, взросшего в жестокой конкуренции дарвиновской эволюции? Раз системы с искусственным интеллектом — продукт искусственного конструирования, а не естественной эволюции, не будут ли они менее амбициозными и более склонными к самопожертвованию?

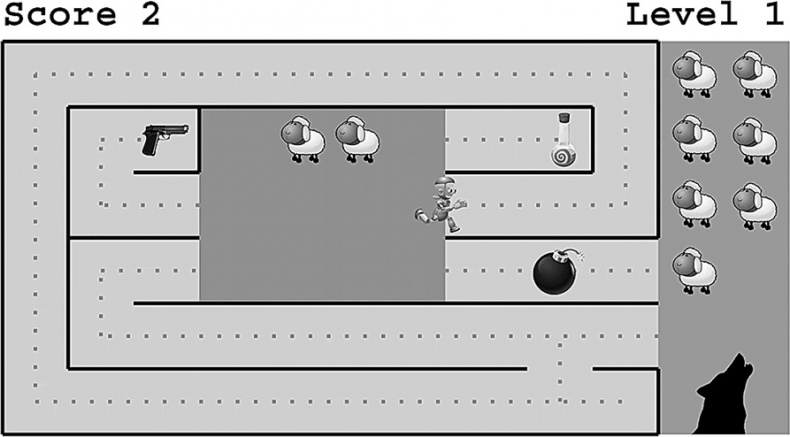

В качестве простого примера давайте рассмотрим рис. 7.3, изображающий робота с искусственным интеллектом, чья единственная цель — спасение наибольшего количества овец от большого злого волка. Это звучит очень благородно и альтруистично и никак не связано с самосохранением и потреблением. Но какой же будет оптимальная стратегия для нашего друга робота? Робот больше не сможет спасать овец, если он подорвется на мине, поэтому у него есть стимул оставаться целым. Другими словами, у него появляется вспомогательная цель — самосохранение! Ему также важно быть любопытным, улучшая свою модель мира, исследуя окружающее, потому что, хотя путь, по которому он сейчас идет, в конце концов приведет к пастбищу, есть и более короткий маршрут, который оставит волкам меньше времени на съедание овец. В конце концов, если робот тщательно все изучит, он поймет и важность потребления ресурсов: энергетический напиток даст ему возможность бежать быстрее, а пистолет позволит стрелять в волка. В итоге мы не можем сказать, что развитие вспомогательных целей «альфа-самца», таких как самосохранение и захват ресурсов, свойственно только эволюционировавшим организмам, потому что наш интеллектуальный робот развил их, имея одну-единственную цель — овечье счастье.

Рис. 7.3

Даже если основной целью робота является получение наивысшего балла за доставку овец от пастбища до загона до того, как волки их съедят, то уже и в этом случае у него возникнут некоторые вспомогательные цели, включающие в себя самосохранение (не подорваться на бомбе), исследования (находить более короткие пути) и потребление ресурсов (энергетический напиток позволит ему бежать быстрее, а пистолет — стрелять в волков).