Человекообразность некоторых роботов уже привела к политическим и эмоциональным затруднениям. 25 октября 2017 г. Саудовская Аравия предоставила гражданство Софии, гуманоидному роботу, представляющему собой, по описанию, не более чем «чатбот с лицом»

[179], даже хуже

[180]. Возможно, это была пиар-акция, но предложение Комитета по юридическим вопросам Европейского парламента звучит совершенно серьезно

[181]. В нем рекомендуется:

…в долгосрочной перспективе создать особый правовой статус для роботов, чтобы, по крайней мере, самые совершенные автономные роботы могли иметь статус электронных личностей, отвечающих за любую принесенную ими пользу и причиненный вред.

Иными словами, сам робот будет нести юридическую ответственность за ущерб, а не его владелец или производитель. Это предполагает, что роботы будут владеть финансовыми активами и подвергаться наказаниям за неподчинение. В буквальном понимании это просто бессмысленно. Например, если мы посадим робота в тюрьму за просрочку платежа, ему-то что?

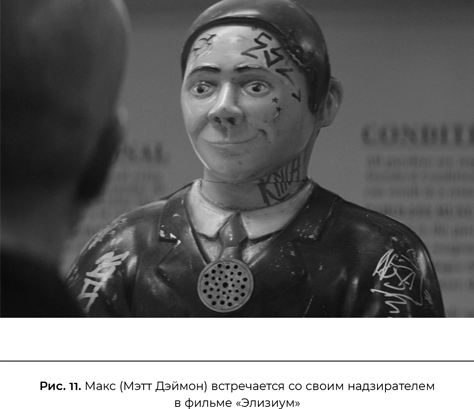

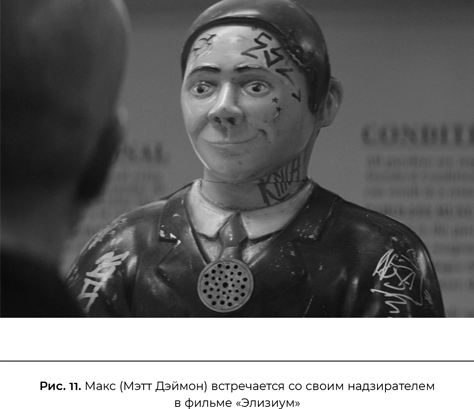

Помимо ненужного и на самом деле абсурдного повышения статуса роботов, имеется опасность, что более активное использование машин в принятии решений, влияющих на людей, принизит статус и достоинство людей. Эта возможность прекрасно показана в сцене из научно-фантастического фильма «Элизиум», когда Макс (которого играет Мэтт Дэймон) пытается объяснить «чиновнику», решающему вопрос о досрочном освобождении (рис. 11), почему продление срока его заключения незаконно. Разумеется, все безрезультатно. Чиновник даже делает Максу выговор за недостаточно почтительное отношение.

Возможны два взгляда на подобное унижение человеческого достоинства. Первый очевиден: давая машинам власть над людьми, мы обрекаем самих себя на более низкий статус и теряем право участвовать в принятии решений, касающихся нас. (Крайней формой этого было бы предоставление машинам права убивать людей, что обсуждалось ранее в этой главе.) Второй подход не столь прямолинеен: даже если вы верите, что решения принимают не машины, а люди, которые их разрабатывают и поставляют, тот факт, что эти люди, разработчики и поставщики, не считают целесообразным учитывать личные обстоятельства человека в каждом конкретном случае, свидетельствует о том, что они не придают особой ценности жизни других людей. Это вероятный симптом начала великого разъединения человечества на элиту, обслуживаемую людьми, и огромную деклассированную массу, которую обслуживают и контролируют машины.

В ЕС статья 22 Общего регламента по защите персональных данных (GDPR) от 2018 г. явно запрещает предоставление власти машинам в подобных случаях:

Субъект данных должен иметь право не подпадать под действие решения, основанного исключительно на автоматической обработке, включая формирование профиля, которое порождает юридические последствия в его отношении или существенно воздействует на него.

В принципе, звучит прекрасно, но пока — во всяком случае, когда пишутся эти строки, — еще неясно, насколько это будет действенно на практике. Часто значительно проще, быстрее и дешевле предоставить право решения машинам.

Одной из причин беспокойства по поводу автоматизированного принятия решений является возможность алгоритмического смещения — тенденции алгоритмов машинного обучения генерировать неправомерно тенденциозные решения о ссудах, жилищных вопросах, рабочих местах, страховании, досрочном освобождении, тюремном заключении, зачислении в колледж и т. д. Явное применение таких критериев, как раса, в этих решениях незаконно уже много десятилетий во многих странах и запрещено статьей 9 Общего регламента по защите данных Евросоюза (GDPR) для очень широкого спектра приложений. Это, конечно, не значит, что, исключив расу из данных, мы обязательно получим расово непредубежденное решение. Например, еще с 1930-х гг. введенная правительством практика «красной черты»

привела к тому, что территории, соответствующие некоторым почтовым индексам в США, оказались отрезаны от ипотечного кредитования и других видов инвестиций, что обернулось снижением стоимости недвижимости. Просто так совпало, что районы с этими индексами были населены главным образом афроамериканцами.

Во избежание политики «красной черты» сегодня только первые три цифры пятизначного почтового индекса могут использоваться при принятии решения о выдаче кредита. Кроме того, процесс принятия решения должен быть поднадзорным, чтобы гарантировать отсутствие любых других «случайных» тенденций. Часто утверждают, что GDPR обеспечивает всеобщее «право на объяснение» многих автоматизированных решений

[182], но в действительности требование статьи 14 — это всего лишь:

…достоверная информация о соответствующей логической схеме, а также о значимости и предполагаемых последствиях указанной обработки для субъекта данных.

В настоящее время неизвестно, как суды будут добиваться исполнения этого положения. Возможно, горемычному потребителю попросту вручат описание определенного алгоритма глубокого обучения, который использовался для натаскивания классификатора, принявшего решение.

Сегодня вероятные причины алгоритмического смещения связаны с данными, а не с намеренными злоупотреблениями корпораций. В 2015 г. журнал Glamour сообщил о неприятном открытии: «Первый связанный с женщиной результат выдачи Google по поисковому запросу „генеральный директор“ оказался лишь двенадцатым — и это была Барби». (В результатах 2018 г. были и реальные женщины, но большинство из них являлись моделями, изображавшими женщин-гендиректоров на стоковых фото; результаты поиска в 2019 г. немного лучше.) Это следствие не сознательной гендерной тенденциозности механизма ранжирования поиска изображений Google, а изначальной необъективности культуры, предоставляющей данные. Мужчин среди генеральных директоров намного больше, чем женщин, и когда люди хотят изобразить «типичного» гендиректора в подписанных изображениях, то почти всегда выбирают мужчину. То, что тенденциозность вызвана, прежде всего, данными, разумеется, не означает, что незачем предпринимать меры для решения этой проблемы.