Можно также построить задачи, в которых Робби как примерный студент будет задавать вопросы, а Гарриет как хороший учитель указывать ему на подводные камни, которых следует избегать. Такое поведение возникает не потому, что мы написали сценарии для Гарриет и Робби, а потому что это оптимальное решение игры в помощника, в которой участвуют Гарриет и Робби.

Игра в выключение

Инструментальной является цель, в общем полезная в качестве подцели практически любой исходной цели. Самосохранение — одна из инструментальных целей, поскольку лишь очень немногих исходных целей легче достичь, будучи мертвым. Это ведет к проблеме выключателя: машина, имеющая фиксированную цель, не позволяет себя выключить и имеет стимул сделать свое выключение невозможным.

Проблема выключателя составляет ядро проблемы контроля интеллектуальных систем. Если мы не можем выключить машину, потому что она нам не дает это сделать, у нас серьезные проблемы. Если можем — значит, мы сумеем контролировать ее и другими способами.

Оказывается, неопределенность в отношении цели имеет принципиальное значение для обеспечения возможности выключить машину — даже если она более интеллектуальна, чем мы. Мы видели неформальный аргумент в предыдущей главе: по первому принципу полезных машин, Робби интересуют только предпочтения Гарриет, однако, согласно второму принципу, он не знает точно, в чем они заключаются. Он знает, что не хочет сделать что-нибудь неправильно, но не знает что. Гарриет, напротив, знает это (или мы так предполагаем в данном простом случае). Следовательно, если она отключит Робби, то именно для того, чтобы не дать ему сделать что-нибудь не так, и он с удовольствием подчинится.

Чтобы уточнить это рассуждение, нужно построить формальную модель проблемы

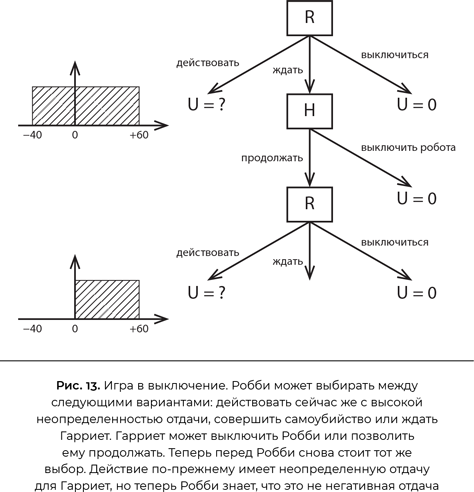

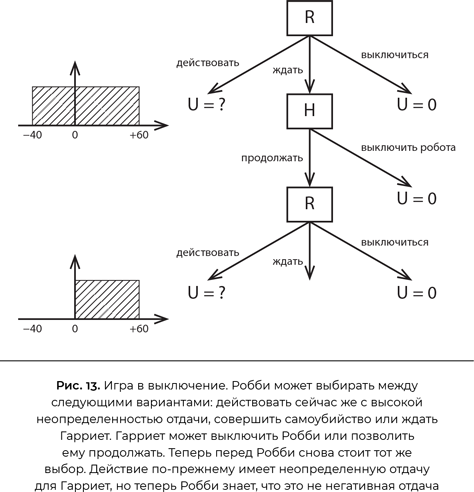

[263]. Я сделаю ее настолько простой, насколько это возможно (рис. 13).

Робби, теперь выступающий в роли персонального помощника Гарриет, делает выбор первым. Он может сразу действовать — к примеру, забронировать Гарриет номер в дорогом отеле. Робот далеко не уверен, что Гарриет понравится отель и цена; допустим, равномерное распределение вероятности его чистой стоимости для Гарриет составляет для Робби от −40 до +60 со средним значением +10. Он также может «выключиться» — без драматичных последствий для себя, просто полностью выйти из процесса бронирования номера в отеле, — ценность этого действия для Гарриет мы оцениваем в ноль. Если бы у него были лишь эти два варианта, он продолжил бы действовать и забронировал номер, что подразумевало бы существенный риск сделать Гарриет несчастной. Однако мы даем Робби третий вариант выбора: изложить свой план, подождать и предоставить Гарриет его выключить. Гарриет может либо выключить робота, либо дать ему возможность продолжить и забронировать номер. Возможно, вы не понимаете, какой в этом смысл, ведь он и сам мог выбрать любой из этих вариантов.

Смысл в том, что выбор Гарриет — отключить Робби или позволить ему продолжить — дает Робби новую информацию о ее предпочтениях. Если она разрешит ему продолжать, то потому, что ценность такого шага для Гарриет является положительной. Теперь Робби верит в равномерное распределение в интервале от 0 до 60 со средним значением 30.

Итак, если оценить первоначальные варианты выбора Робби с этой точки зрения, получаем следующее:

• Выбор «действовать сейчас и забронировать номер» имеет ожидаемую ценность +10.

• Выбор «выключиться» имеет ценность 0.

• Выбор «подождать и позволить Гарриет выключить его» (если она этого хочет) ведет к двум возможным результатам:

— имеется 40 %-ная вероятность (исходя из неуверенности Робби в связи с отелем), что Гарриет он ужасно не понравится и она выключит Робби, ожидаемая ценность 0;

— имеется 60 %-ная вероятность, что Гарриет он понравится и она позволит Робби продолжить, ожидаемая ценность +30.

• Таким образом, решение «подождать» имеет ожидаемую ценность 40 % × 0 + 60 % × 30 = +18, что лучше, чем «действовать сейчас» с ценностью +10.

Итак, Робби имеет положительный стимул позволить себя выключить. Этот стимул напрямую вытекает из неопределенности, имеющейся у Робби в отношении предпочтений Гарриет. Робби сознает существующую вероятность (40 % в данном примере), что он, возможно, близок к действию, которое сделает Гарриет несчастной, и в этом случае быть выключенным предпочтительней, чем продолжать. Если бы Робби уже был уверен в предпочтениях Гарриет, то просто продолжил бы и принял решение (или выключился). Консультация с Гарриет совершенно ничего не принесла бы, поскольку, согласно твердой убежденности Робби, он и так может точно предсказать, какое решение она примет.

На самом деле можно доказать тот же результат для общего случая: пока у Робби нет полной уверенности, что он собирается сделать то же самое, что сделала бы сама Гарриет, он будет отдавать предпочтение варианту, в котором позволяет ей отключить себя

[264]. Ее решение снабжает Робби информацией, а информация всегда полезна для совершенствования его решений. Напротив, если Робби уверен в решении Гарриет, то оно не приносит никакой новой информации, следовательно, у Робби нет стимула позволять ей решать.

Напрашивается несколько модификаций этой модели, заслуживающих безотлагательного рассмотрения. Первая состоит в том, чтобы приписать стоимость обращению к Гарриет с тем, чтобы она приняла решение или ответила на вопрос (то есть мы предполагаем, что Робби знает предпочтения Гарриет хотя бы в той мере, чтобы понимать, что ее время ценно). В этом случае Робби менее склонен отвлекать Гарриет, если он почти уверен в ее предпочтениях; чем выше стоимость, тем в большей неопределенности должен находиться Робби, чтобы побеспокоить Гарриет. Так оно должно быть. Если же Гарриет всерьез недовольна, когда ее отвлекают, ей не следует удивляться, что Робби временами делает то, что ей не нравится.