Так, власти и исследовательские институты некоторых стран (Пакистана, Китая, Южной Кореи и Японии) даже ввели премии на основе цифрового значения импакт-фактора того или иного журнала, несмотря на то что эти значения в различных дисциплинах несопоставимы между собой

[184]. В результате давление на ученых еще более усилилось и некоторые из них дошли до того, что ради публикации своих статей стали манипулировать журнальной системой рецензирования. Когда махинации вскрывались, издателям журналов приходилось отзывать публикацию статей, прошедшие лжерецензирование, то есть отрецензированные самими их авторами

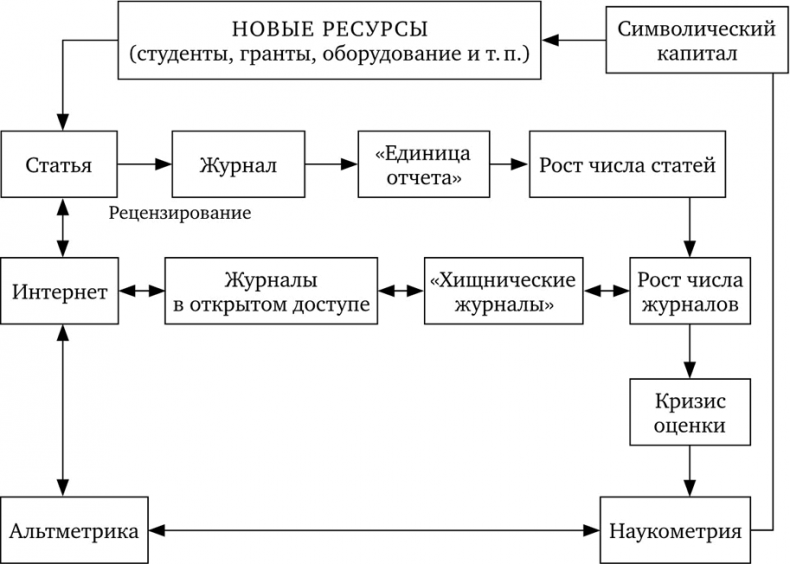

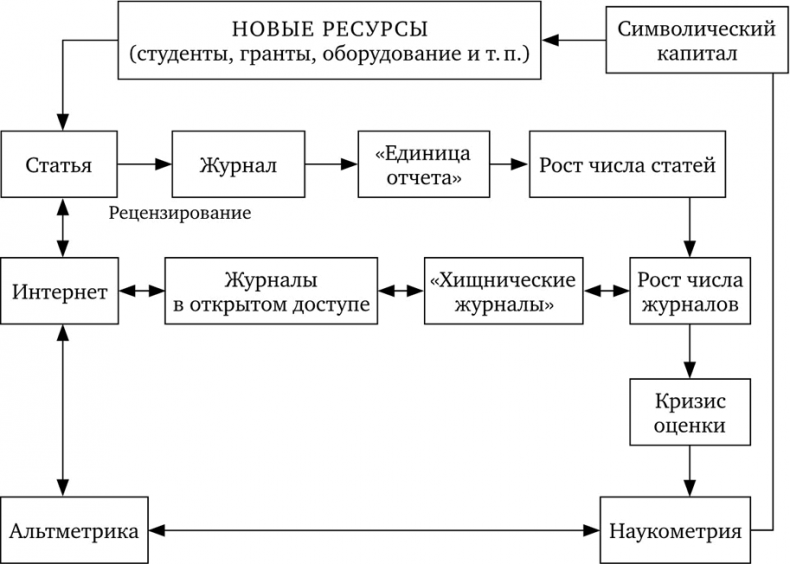

[185]. Таким образом, эти новые метрики могут напрямую влиять на доступ к необходимым для проведения исследований ресурсам (схема 2).

Схема 2. Изменения в классическом цикле оценки (см. схему 1) вследствие превращения научной статьи в простую «единицу отчета» исследовательской деятельности, породившего целый ряд посредников и новых оценочных метрик

Ученые и специалисты по библиометрии неоднократно критиковали процедуры оценки, основанные на импактфакторе журналов. После десяти с лишним лет острой критики многие журналы, включая Nature и другие «элитные» издания, стали понемногу дистанцироваться от этого индикатора, который они долгое время использовали для своего брендирования, не желая более иметь ничего общего с примитивными методами оценки, грозящими запятнать их репутацию

[186]. Поскольку считается, что журналы публикуют единицы знаний, они противятся превращению в простой измерительный инструмент. Похожая ситуация сложилась и с академическим книгоизданием в 1990-е годы. Когда в университетские издательства хлынул поток книг, необходимых их авторам для занятия профессорских должностей, они призвали университеты перестать увязывать карьерное продвижение с наличием такого рода публикаций

[187].

В связи с тем, что количественные показатели продуктивности и импакта отныне заняли центральное место, был создан новый рынок для компаний, предлагающих свои услуги по «оценке» исследователей, лабораторий и университетов

[188]. Поскольку статьи и журналы превратились в «единицы отчета», владеющие журналами компании получили возможность позиционировать себя на рынке как производителей новых оценочных индикаторов, основывающихся на их собственной подборке журналов. Параллельно они подталкивали институции к тому, чтобы те призывали своих исследователей публиковаться в их самопровозглашенных «высококачественных» журналах. Лучший пример такой стратегии — это созданный в 2014 году Nature Index, который котирует страны и институции на основе публикаций, издающихся всего лишь в 68 журналах, определяемых как «высококачественные научные журналы». При этом среди них 17 (25 %) относятся к группе Nature (принадлежавшей издательству «Мак-Миллан», недавно создавшему совместное предприятие со «Шпрингером»), которая является одним из крупнейших издателей научных журналов. Говорится, что этот новый рейтинг позволяет «составить картину высококачественных исследований на основе публикуемых статей» и «предоставляет институциям простой способ выявлять и выдвигать на первый план свои лучшие научные исследования».

Распространение интернета не только радикально изменило способ обращения научных статей, но и повлияло на то, какого рода метрики стали продвигаться для измерения «импакта» исследований (которому редко дается четкое определение). В интернете можно получить доступ к статье и быстро просмотреть ее фрагмент на экране, а можно скачать копию целой статьи. Эти действия оставляют следы и тем самым создают новые данные об «использовании» научных статей. В этой ситуации получила распространение так называемая «альтметрика», которую представляют как альтернативу анализу цитирования, хотя в действительности при ее помощи измеряют нечто другое

[189]. Если цитирование — это часть внутринаучного процесса, измерение практик использования публикаций в интернете охватывает более широкий спектр пользователей с неизвестным профилем, являющихся частью более широкого социального пространства: ведь по «кликам» мы не можем определить, исходят ли они от обычного гражданина или от публикующегося исследователя. Расширяя арсенал библиометрии, метрики заметности публикаций в интернете по-своему способствуют измерительной лихорадке вокруг «импакта» академических исследований, хотя при этом по-прежнему остается неуловимой суть этого самого «импакта». Сторонники новых веб-метрик часто повторяют, что получение ссылок на статью занимает годы, тогда как «просмотры» и «скачивания» доступны в реальном времени, день за днем и даже час за часом. Добавляя блоги и твиты к арсеналу библиометрии, мы, конечно, получаем инструмент для отслеживания того, как научные результаты распространяются внутри разных сообществ, но это мало что говорит о качестве и даже о научности публикуемых результатов. Более того, эти новые виды метрик имеют совершенно иную темпоральность и охватывают другие типы аудиторий. Так, если временным горизонтом для культуры цитирования, характерной для научного поля, являются годы, то блоги и твиты оперируют в более широком социальном пространстве, появляясь, видоизменяясь и исчезая за считанные дни (блоги) или часы (твиты). Можно было бы ожидать от ученых более критического отношения к институциям, пытающимся использовать столь примитивные и неточные библиометрические методы для оценки «импакта» их исследований, будь то социальный, экономический, культурный или какой-либо иной. Однако под прессом необходимости постоянно доказывать полезность научных исследований лаборатории и университеты склонны пасовать, подчиняясь циничному использованию подобной библиометрии, если она отвечает их целям — подобно тому, как это происходит с так называемым «мировым рейтингом университетов», несмотря на его очевидные пороки

[190].