Участникам конкурса предоставили огромное количество данных о почти полумиллионе пользователей Netflix и около миллиона анонимных мнений, оценивающих 17 700 фильмов. Задача состояла в том, чтобы предсказать, как пользователи оценят фильмы, которых еще не видели. Есть данные – много данных, имеющих непосредственное отношение к поведению, – и вы пытаетесь прогнозировать это поведение. Очень сложная задача. В итоге прошло целых три года, прежде чем кто-то смог превысить 10 %-ную планку, причем произошло это, лишь когда несколько групп, принимавших участие в конкурсе, объединились и создали гибрид «почти пригодных» алгоритмов. Они надеялись, что это мощное алгоритмическое чудо выведет их на финишную прямую. Netflix так и не использовала победивший алгоритм в своем бизнесе, поскольку к моменту завершения конкурса компания уже переходила от рассылки DVD-дисков по почте к трансляции фильмов методом потокового вещания, что делало неиспользованные рекомендации совсем бесполезными

{142}. Наверняка кто-то из вас пользовался услугами Netflix (или Amazon, или Facebook, или любого сайта, пытающегося навязать вам выбор продуктов на основании собранных о вас данных), поэтому вы и без меня знаете, насколько неудачны и до смешного нелепы их рекомендации. Но, по мере того как ваш профиль начнет пополняться все большим количеством данных, их советы будут становиться более уместными. А может быть, и не будут.

С точки зрения таких компаний, нет ничего плохого в том, что они занимаются сбором и уточнением ваших данных. Конечно, для Target было бы удобнее всего, если они могли бы точно узнавать о беременности клиенток, отслеживая данные на их карточках постоянного покупателя. Но они этого не могут и потому не знают, беременны вы или нет. Тем не менее даже догадки о вашей беременности принесли бы компании пользу и дали бы возможность делать свои прогнозы на 10 % точнее, чем сейчас. То же самое касается Google. Компании нет необходимости точно знать, какой продукт вы хотите приобрести; все, что ей нужно, – иметь чуть более точное представление о ваших предпочтениях, чем конкурирующие фирмы. Как правило, компании работают с невысокой рентабельностью. Для вас нет ничего страшного, прогнозируете ли вы свое поведение точнее хотя бы процентов на десять или нет, но для компаний 10 % – это довольно большие деньги. Во время проведения конкурса я спросил вице-президента Netflix Джима Беннетта, который занимался вопросами рекомендаций, почему компания предложила столь большой приз. Он ответил, что мне следовало бы спросить, почему приз такой маленький. На первый взгляд небольшое повышение эффективности рекомендаций на 10 % позволило бы возместить этот миллион долларов за меньшее время, чем то, которое понадобилось для создания еще одного фильма The Fast and the Furious («Форсаж»).

Знает ли Facebook, что вы террорист?

Итак, корпорации, имеющие доступ к большим массивам информации, по-прежнему обладают довольно ограниченными знаниями о ваших персональных данных. Что тогда вас волнует?

И все-таки причины для беспокойства есть. Вот одна из них. Предположим, группа специалистов Facebook решает разработать метод определения, кто из пользователей социальной сети может быть причастен к террористической деятельности, направленной против Соединенных Штатов Америки. В математическом плане эта задача не сильно отличается от определения вероятности, что пользователю Netflix понравится фильм Ocean’s Thirteen («Тринадцать друзей Оушена»). Как правило, Facebook известны реальные имена пользователей и их место жительства, поэтому компания может использовать информацию из открытых источников для составления списка профилей, принадлежащих людям, уже имевшим судимости за террористические преступления или за поддержку террористических группировок. Далее начинается математика. Склонны ли террористы делать больше обновлений в день по сравнению с общей совокупностью пользователей этой социальной сети? или меньше? или этот показатель у них такой же, как и у всех остальных? Есть ли слова, которые чаще появляются в их обновлениях? Есть ли музыкальные группы, спортивные команды или продукты, к которым они особенно испытывают или не испытывают симпатию? Сложив все это вместе, вы можете присвоить каждому пользователю балл

[146], отражающий вашу лучшую оценку вероятности, что у данного пользователя есть или будут связи с террористическими группировками. Примерно то же самое делают в Target, когда сопоставляют данные о ваших покупках для определения вероятности, беременны вы или нет.

Однако существует одна важная особенность: беременность – явление довольно распространенное, тогда как терроризм – скорее редкое. Почти во всех случаях расчетная вероятность того, что данный пользователь станет террористом, крайне мала. Таким образом, итогом этого проекта стал бы не центр профилактики преступлений – как в фильме Minority Report («Особое мнение»), – в котором всеобъемлющий алгоритм Facebook раньше вас узнает, что вы собираетесь совершить преступление. Представьте себе нечто более непритязательное: скажем, список сотен тысяч пользователей, о которых Facebook с определенной степенью достоверности может сказать следующее: «Вероятность того, что люди из этой группы могут быть террористами или пособниками терроризма, в два раза больше, чем в случае обычных пользователей Facebook».

Что вы сделаете, если обнаружите, что человек, входящий в этот список, живет с вами по соседству? Наверное, позвоните в ФБР?

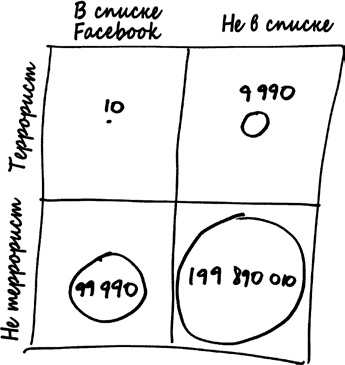

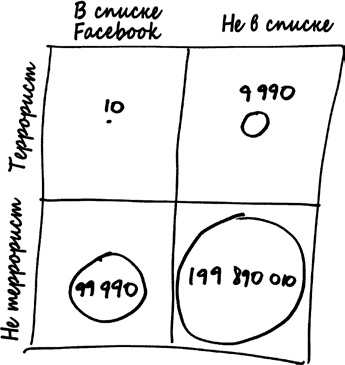

Прежде чем предпринимать этот шаг, давайте нарисуем еще одну матрицу.

Содержимое этой матрицы – около 200 миллионов пользователей сети Facebook в Соединенных Штатах. Линия между верхней и нижней частями матрицы отделяет будущих террористов (верхняя часть) от невиновных (нижняя часть). Безусловно, любая террористическая ячейка в США довольно немногочисленна. Скажем, если быть максимально подозрительными, в стране есть около 10 тысяч людей, за которыми федералам действительно стоит присматривать. Это один из каждых 20 тысяч пользователей общей пользовательской базы.

Разделение матрицы на левую и правую часть, собственно, и есть то, что делает Facebook: с левой стороны находится сотня тысяч людей, которых в Facebook считают с высокой степенью вероятности связанными с терроризмом. Давайте поверим Facebook на слово, будто их алгоритм настолько хорош, что отмеченные таким образом люди могут быть террористами с вероятностью в два раза большей, чем обычные пользователи. Следовательно, в этой группе один из 10 тысяч пользователей, или 10 человек, окажутся террористами, тогда как 99 990 – нет.