Длинный хвост

Метод обучения с учителем, требующий больших данных и целых армий аннотаторов, хорошо работает по крайней мере с некоторыми зрительными способностями, необходимыми беспилотным автомобилям. (Многие компании также проверяют возможность использования напоминающих видеоигры программ-тренажеров, чтобы дополнить обучение с учителем.) Но что насчет остальной жизни? Почти каждый, кто работает в сфере ИИ, согласен, что обучение с учителем нельзя считать перспективным путем к созданию общего ИИ. Знаменитый исследователь ИИ Эндрю Ын предупреждает: “Сегодня необходимость такого большого объема данных серьезно ограничивает [глубокое обучение]”

[137]. С ним согласен другой известный исследователь ИИ, Йошуа Бенджо: “У нас нет реальной возможности разметить весь мир и педантично объяснить все до последней детали компьютеру”

[138].

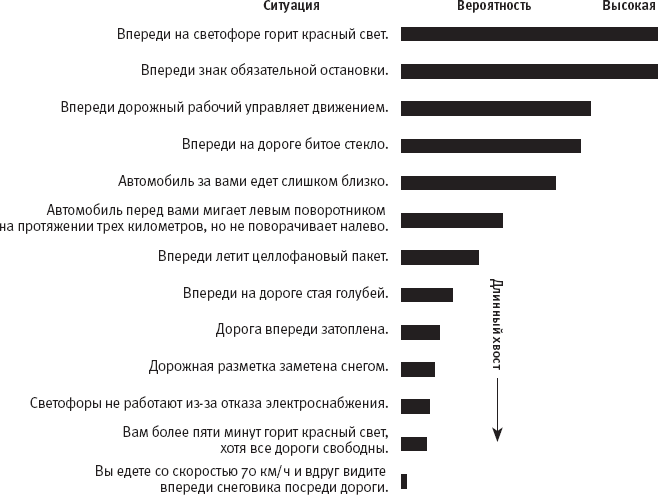

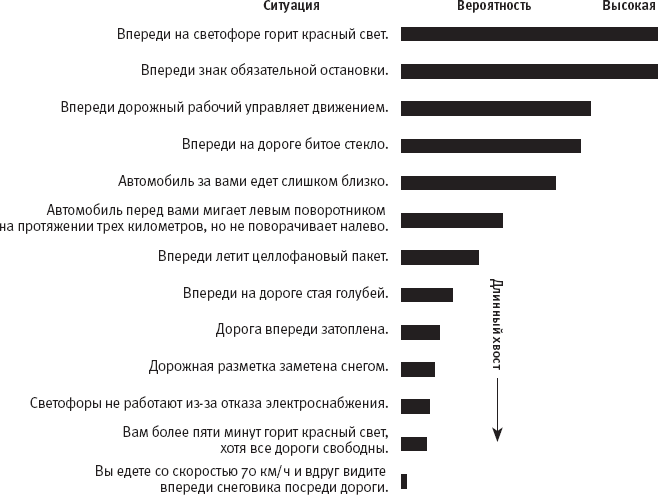

Рис. 13. Ситуации, с которыми может столкнуться беспилотный автомобиль, выстроенные по вероятности возникновения в качестве иллюстрации “длинного хвоста” маловероятных сценариев

Ситуацию осложняет так называемая проблема длинного хвоста: огромный диапазон возможных непредвиденных ситуаций, с которыми может столкнуться система ИИ. На рис. 13 показано, какова вероятность возникновения различных гипотетических ситуаций, скажем, за один день езды беспилотного автомобиля. Вероятность возникновения типичных ситуаций, в которых автомобиль, например, увидит красный сигнал светофора или знак обязательной остановки, высока. Ситуации со средней вероятностью возникновения – появление на дороге битого стекла или летающего на ветру целлофанового пакета – возникают не каждый день (в зависимости от того, где ездить), но в них нет ничего необычного. Менее вероятно, что беспилотный автомобиль заедет на затопленную дорогу или не сумеет различить дорожную разметку, заметенную снегом, и еще менее вероятно, что посреди скоростного шоссе окажется снеговик.

Я выдумала эти сценарии и оценила их относительную вероятность. Уверена, вы можете продолжить мой список. Любой отдельный автомобиль, скорее всего, безопасен: в конце концов, в совокупности экспериментальные беспилотные автомобили проехали миллионы километров и стали причиной относительно небольшого количества аварий (хотя среди них оказалось несколько серьезных ДТП с человеческими жертвами). Однако, хотя каждая маловероятная ситуация по определению крайне маловероятна, в мире дорожного движения столько возможных сценариев и столько автомобилей, что при широком распространении беспилотников некоторые из них, вполне вероятно, рано или поздно где-нибудь столкнутся с одним из маловероятных сценариев.

Термин “длинный хвост” пришел из статистики, где некоторые распределения вероятностей имеют форму, сходную с изображенной на рис. 13, и длинный список крайне маловероятных (но возможных) ситуаций называется “хвостом” распределения. (Ситуации в хвосте иногда называются пограничными случаями.) Такой феномен наблюдается в большинстве практических применений ИИ: события в реальном мире обычно предсказуемы, но остается длинный хвост маловероятных, непредвиденных ситуаций. Это становится проблемой, только если мы полагаемся исключительно на обучение с учителем при обеспечении нашей ИИ-системы знаниями о мире: в обучающих данных недостаточно примеров ситуаций из длинного хвоста – если такие примеры есть вообще, – а потому система более склонна к совершению ошибок при столкновении с такими непредвиденными обстоятельствами.

Рис. 14. Сообщалось, что полоски соли на шоссе, рассыпанные в преддверии снегопада, сбивали автопилот автомобилей Tesla

Приведу два реальных примера. В марте 2016 года на северо-востоке США прогнозировали сильную метель, и в Twitter появились сообщения, что автопилот автомобилей Tesla, позволяющий ограниченное беспилотное вождение, не отличает дорожную разметку от полосок соли, рассыпанных по шоссе в преддверии снегопада (рис. 14). В феврале 2016 года один из прототипов беспилотного автомобиля Google, выполняя правый поворот, отклонился влево, чтобы объехать мешки с песком у правого края калифорнийской дороги, и левым передним крылом задел городской автобус, который двигался по левой полосе. Каждое из транспортных средств ожидало, что другое уступит ему дорогу (возможно, водитель автобуса ожидал, что за рулем автомобиля сидит человек, который испугается гораздо более крупного автобуса).

Компании, развивающие технологию беспилотного вождения, прекрасно осведомлены о проблеме длинного хвоста: их сотрудники обсуждают возможные “хвостовые” сценарии и активно разрабатывают дополнительные обучающие примеры, а также особым образом запрограммированные стратегии поведения во всех маловероятных ситуациях, которые приходят им в голову. Тем не менее невозможно обучить или запрограммировать систему на верное поведение абсолютно в любой возможной ситуации.

Обычно для решения этой проблемы системам ИИ предлагается использовать обучение с учителем на небольших объемах размеченных данных, а все остальное узнавать, применяя обучение без учителя. Термином “обучение без учителя” обозначается большая группа методов, которые позволяют системе узнавать категории и действия, не имея размеченных данных. К таким методам относятся кластеризация изображений на основе сходства или обнаружение новой категории по аналогии с известными. Как я опишу в одной из последующих глав, люди великолепно справляются с выявлением абстрактных сходств и аналогий, но пока не существует достаточно успешных ИИ-методов для такого обучения без учителя. Даже Ян Лекун признает, что “обучение без учителя остается темной материей ИИ”. Иными словами, для создания общего ИИ почти все обучение должно проходить без учителя, но пока никто не предложил эффективных алгоритмов для осуществления обучения без учителя.

Люди совершают ошибки постоянно, даже (или особенно) при вождении, и любой из нас мог столкнуться с городским автобусом, объезжая мешки с песком. Но люди при этом обладают важнейшей способностью, которой не хватает современным системам ИИ: они умеют пользоваться здравым смыслом. Мы обладаем огромными фоновыми знаниями о мире – физическом и социальном. Мы хорошо представляем, как обычно ведут себя объекты – живые и неживые, – и активно пользуемся этими знаниями, решая, как действовать в конкретной ситуации. Мы можем понять, почему на дороге рассыпана соль, даже если ни разу в жизни не ездили в снегопад. Мы понимаем, как взаимодействовать с другими людьми, а потому можем пользоваться зрительным контактом, жестами и языком тела, если светофоры перестают работать после отказа электроснабжения. Обычно мы уступаем дорогу большому городскому автобусу, даже если по правилам имеем преимущество. Я использовала примеры из дорожного движения, но мы, люди, пользуемся здравым смыслом – обычно бессознательно – на каждом шагу. Многие полагают, что пока системы ИИ не обретут здравый смысл, доступный людям, мы не сможем позволить им полную автономность в сложных реальных ситуациях.