Вот лишь несколько примеров вредоносных атак, описанных различными исследовательскими группами. Многие потенциальные атаки на удивление надежны: они работают в нескольких разных сетях, даже если эти сети обучены на разных наборах данных. При этом сети можно обмануть не только в сфере компьютерного зрения – исследователи также разрабатывают атаки, обманывающие глубокие нейронные сети, имеющие дело с языком, в том числе с распознаванием речи и анализом текста. Можно ожидать, что при распространении этих систем в реальном мире злонамеренные пользователи обнаружат в них множество других уязвимостей.

Сейчас исследователи уделяют огромное внимание изучению потенциальных атак и разработке способов защиты от них. Хотя решения для конкретных типов атак уже найдены, общий механизм защиты пока не создан. Как и в других сферах компьютерной безопасности, прогресс здесь носит эпизодический характер: стоит выявить и залатать одну брешь в безопасности, как находятся другие, требующие другой защиты. “Сейчас модели машинного обучения можно причинить почти любой мыслимый вред… – говорит специалист по ИИ Ян Гудфеллоу, входящий в команду Google Brain. – И защитить ее очень, очень сложно”

[152].

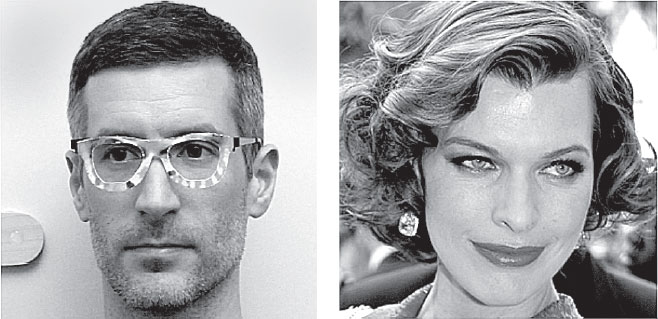

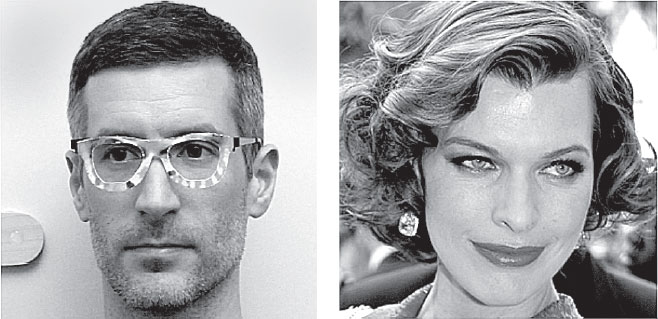

Рис. 20. Исследователь ИИ (слева) в очках с особым узором на оправе, созданных специально для того, чтобы система распознавания лиц на базе глубокой нейронной сети, тренированная на лицах знаменитостей, уверенно распознавала левую фотографию как портрет актрисы Миллы Йовович (справа). В описывающей это исследование статье приводится множество других примеров маскировки с помощью “состязательных” оправ

Помимо необходимости защиты сетей от атак, существование контрпримеров обостряет вопрос, который я задавала ранее: чему именно обучаются эти сети? В частности, чему они обучаются, чтобы их было так просто обмануть? А может – что важнее, – это мы обманываем себя, считая, что сети действительно усваивают концепции, которым мы пытаемся их научить?

На мой взгляд, в корне всего этого лежит проблема понимания. Взгляните на рис. 18, где AlexNet принимает школьный автобус за страуса. Почему такое вряд ли случилось бы с человеком? Хотя AlexNet очень хорошо справляется с классификацией изображений ImageNet, мы, люди, смотрим на объекты и понимаем многие вещи, которые не понимает ни AlexNet, ни любая другая современная система ИИ. Мы знаем, как выглядят объекты в трехмерном мире, и можем представить их форму, посмотрев на двухмерную фотографию. Мы знаем, какую функцию выполняет конкретный объект, каким образом его части задействованы в выполнении этой функции и в каких контекстах он обычно появляется. Глядя на объект, мы вспоминаем, как смотрели на такие же объекты в других обстоятельствах и с других ракурсов, а также воскрешаем в памяти иные сенсорные модальности (каков этот объект на ощупь, какой у него запах, возможно, какой звук он издает при падении и т. д.). Все эти фоновые знания питают человеческую способность надежно распознавать конкретный объект. Даже самые успешные системы компьютерного зрения не обладают таким пониманием и надежностью, которую оно обеспечивает.

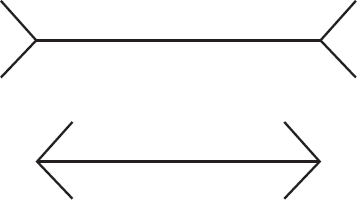

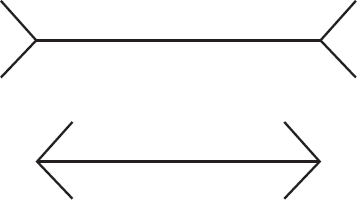

Я слышала, как некоторые исследователи ИИ утверждают, что люди тоже уязвимы для “контрпримеров” особого типа – оптических иллюзий. Как и AlexNet, считающая школьный автобус страусом, люди делают ошибки восприятия (например, нам кажется, что верхний отрезок на рис. 21 длиннее нижнего, хотя на самом деле их длина одинакова). Однако человеческие ошибки отличаются от ошибок сверточных нейронных сетей: в процессе эволюции мы научились очень хорошо распознавать объекты в повседневной жизни, поскольку от этого зависит наше выживание. В отличие от современных сверточных нейронных сетей, люди (и животные) воспринимают мир, опираясь на свои когнитивные способности – своеобразное контекстно-зависимое понимание, которое я описала выше. Кроме того, сверточные нейронные сети, применяемые в современных системах компьютерного зрения, как правило, полностью выстроены на прямых связях, в то время как человеческая зрительная система имеет гораздо больше обратных, чем прямых связей. Хотя нейробиологи пока не понимают функцию этих обратных связей, можно предположить, что хотя бы некоторые из них защищают систему от уязвимости к контрпримерам, свойственной сверточным нейронным сетям. Почему бы не обеспечить сверточные нейронные сети такими обратными связями? Сейчас в этой области ведутся активные исследования, но пока создание сетей с обратной связью остается очень сложной задачей и не приносит таких успехов, как создание сетей с прямой связью.

Рис. 21. Оптическая иллюзия для людей: длина горизонтальных отрезков A и B одинакова, но большинству людей кажется, что отрезок A длиннее отрезка B

Исследователь ИИ из Университета Вайоминга Джефф Клюн провел провокационную аналогию, отметив, что по-прежнему “очень интересно, что такое глубокое обучение – «настоящий разум» или Умный Ганс”

[153]. Умным Гансом звали коня, который жил в начале XX века в Германии и – по утверждению владельца – умел производить арифметические операции и понимал немецкий язык. Конь отвечал на вопросы вроде “Сколько будет пятнадцать разделить на три?”, отстукивая копытом верный ответ. Когда Умный Ганс прославился на весь мир, тщательное расследование выявило, что на самом деле конь не понимал вопросов и математических концепций, а стучал копытом в ответ на едва заметные, бессознательные подсказки человека, который задавал вопрос. С тех пор Умным Гансом называют любого человека (или программу!), который, казалось бы, понимает, что делает, но на самом деле просто реагирует на нечаянные подсказки учителя. Можно ли сказать, что глубокое обучение демонстрирует “истинное понимание”, или же оно, как компьютерный Умный Ганс, реагирует на мелкие подсказки в данных? В настоящее время в среде ИИ не угасают ожесточенные споры об этом, и ситуация осложняется тем, что исследователи ИИ порой расходятся в своих представлениях об “истинном понимании”.

С одной стороны, глубокие нейронные сети, прошедшие обучение с учителем, очень хорошо (хотя совсем не идеально) справляются со множеством задач в сфере компьютерного зрения, а также в других областях, включая распознавание речи и переводы с языка на язык. Поскольку эти сети обладают впечатляющими способностями, их все быстрее выводят за пределы исследовательских лабораторий и начинают применять в реальном мире – в интернет-поиске, беспилотных автомобилях, распознавании лиц, виртуальных помощниках и рекомендательных системах. С каждым днем нам все сложнее представить жизнь без этих инструментов ИИ. С другой стороны, некорректно говорить, что глубокие сети “учатся самостоятельно” или что процесс их обучения “подобен человеческому”. Признавая успехи этих сетей, не стоит забывать, что они могут подводить нас неожиданным образом из-за переобучения на обучающих данных, эффекта длинного хвоста и уязвимости для взлома. Более того, часто сложно понять, по какой причине глубокие нейронные сети принимают решения, а потому нам сложнее прогнозировать и исправлять их ошибки. Исследователи активно работают над тем, чтобы сделать глубокие нейронные сети более надежными и прозрачными, но остается вопрос: приведет ли свойственный сетям недостаток человеческого понимания мира к тому, что они станут хрупкими, ненадежными и уязвимыми для атак? И каким образом это следует учитывать, принимая решения об использовании систем ИИ в реальном мире? В следующей главе мы рассмотрим некоторые серьезные трудности, возникающие при попытке найти баланс между преимуществами ИИ и рисками его ненадежности и злоупотребления им.